都说英伟达是 AI 淘金热潮下的「卖铲人」,但大模型的上游赢家不只是英伟达和台积电,还有以 SK 海力士为代表的 HBM(高带宽内存)厂商。SK 海力士预计,HBM 将于每年 30%左右的速度增长,到 2030 年总规模将达到约 980 亿美元。

在大模型推理的世界里,HBM 几乎是性能与效率的代名词。无论是 GPT-5 这样的通用模型,还是面向垂直领域的专用大模型,推理阶段都要频繁访问海量的 Key-Value 缓存(KV Cache)。这些缓存像「记忆」一样存放着模型已处理过的上下文信息,而它们的读写速度,直接取决于显存带宽和容量:

这也是 HBM 的强项。

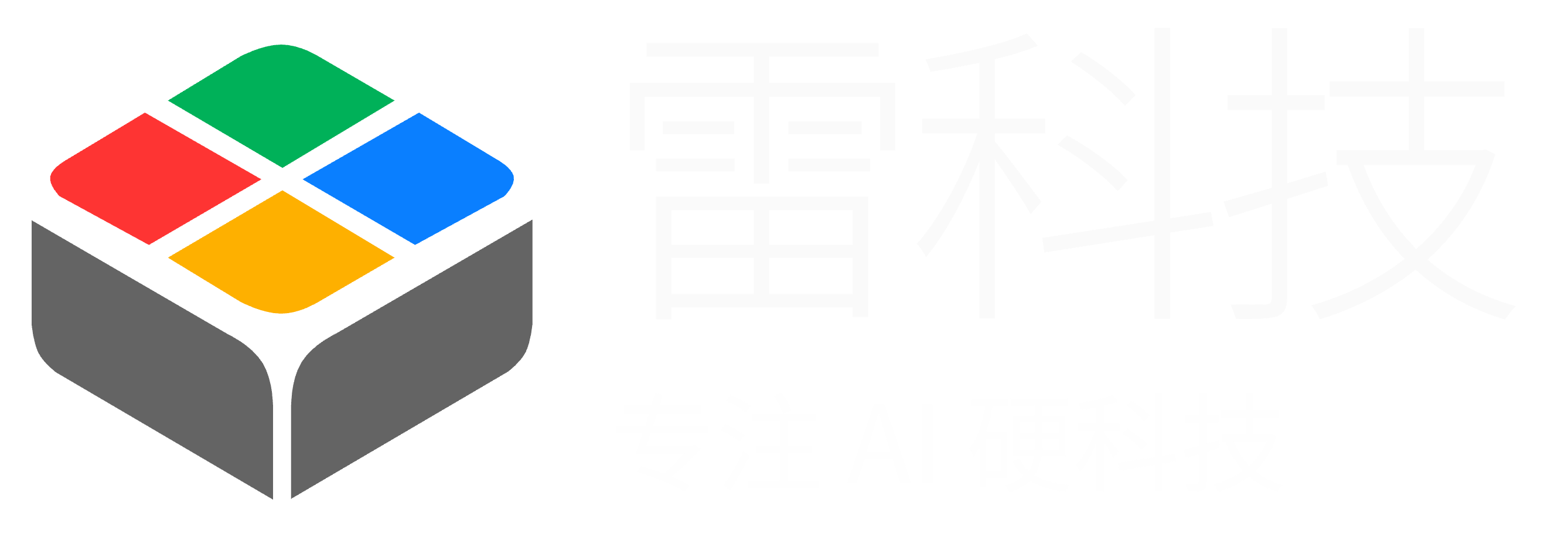

但 HBM 昂贵、稀缺,还被产能掣肘,直接成了当下推理性能和成本之间的一道硬门槛。不过就在最近举办的一场活动上,华为推出了与银联联合打造的一项 AI 推理新技术 ——UCM(Unified Cache Manager,统一缓存管理器),直指大模型推理中对 HBM 依赖过重的顽疾。

图片来源:华为

UCM 的核心思路并不神秘:不是把所有「记忆」都塞进贵又稀缺的 HBM,而是根据热度分区——常用的放在高速区,不常用的转移到更便宜、更容易扩展的存储里。这样一来,HBM 的压力减轻了,模型依然能快速响应,而且能记得更多内容。

更重要的是,UCM 把这一切封装成一个可适配多种推理引擎的统一套件,在软件层面重新定义推理存储调度的规则。

而按照华为的说法,这套技术能让长对话或长文本处理的速度大幅提升,首个字的生成时间缩短到原来的十分之一,模型的「记忆范围」扩展到过去的十倍。对于一个高度依赖硬件的领域来说,这听起来像是通过软件把硬件的瓶颈松开了一道口子:

几乎在改变 AI 推理的游戏规则。

为什么HBM需要UCM来救场?

在 AI 进入日常生活的今天,大模型的「推理」——也就是 AI 理解问题、给出答案的过程,才是真正创造价值的环节。问题是,推理体验并不总是令人满意,尤其是在国内。

在华为推出 UCM 技术的活动上,华为昇腾计算产品部总裁周跃峰博士就指出,今天模型训练、推理效率与体验都以 Token 数为量纲,「由于在基础设施投资当中的差距,中国互联网的大模型首 Token 时延普遍慢于海外互联网头部的首 Token 时延。」

图片来源:华为

不仅如此,生成 Token 的效率也更低。按照华为公布的数据,海外主流模型的单用户输出速度进入了 200 Tokens/s 区间(时延 5ms),但国内普遍小于 60Tokens/s(时延 50 - 100ms)。

简单来说,国内 AI 用户在同等问题下得到回复的速度可能更慢,甚至在处理长对话、长文档时,模型会「遗忘」上下文——看了这一段忘了上一段,看了下一段又忘了前面。而造成这种差距的一个重要原因就是:AI 推理的「记忆力」瓶颈。

问题在于,过去的推理系统几乎只用到了 HBM 和 DRAM,而对 SSD 这类低成本、大容量的存储几乎没有利用。这就像一个人只用脑袋和短期记忆,不用笔记本和外部存档,结果是要么记不住全部内容,要么被大量不常用的信息挤占了「脑子」里最宝贵的空间。

事实上,华为推出 UCM 要解决的,就是这种「内存结构失衡」的问题。UCM 通过算法把推理过程中的数据按热度和延时需求分级存放:实时需要的热数据放在 HBM ,中期会用到但不那么紧急的数据放到 DRAM,而那些体量大但访问频率低的「冷数据」则下沉到 SSD。

这样一来,HBM 可以专心处理最高优先级的任务,不再被冷数据「占坑」,整个系统的推理效率就能被充分释放。而 UCM 也并非一个孤立的软件工具,它由三部分组成:

1. 连接器:与主流推理引擎框架对接,例如华为自家的 MindiE、SGLang,以及业界常用的 vLLM,让不同系统都能无缝接入 UCM。

2. 加速程序:运行在智算服务器上的分级缓存管理算法,负责在不同存储层之间灵活调度数据。

3. 协同器:与专业共享存储打通,优化数据直通效率,降低 SSD 等慢速存储的延迟,实现三层存储的协同工作。

图片来源:华为

按照华为的测试,UCM 可以实现首 Token 时延最高可降低 90%,系统吞吐率提升可达 22 倍,上下文窗口则能扩展到 10 倍级。换句话说,模型不仅能更快开口说话,还能一次记住更多对话和文本内容。

更重要的是,华为计划在 9 月开源 UCM,首发魔擎社区,并把相关组件贡献给更多推理引擎生态。这意味着,UCM 不只是华为昇腾 AI 芯片的专属加速手段,而是一个全行业都可以用的「推理记忆升级包」。

而在推理性能和用户体验已经成为竞争关键的当下,UCM 的应用和开源,很可能将成为一个关键转折点,彻底改变 HBM 内存的使用方式和效率。

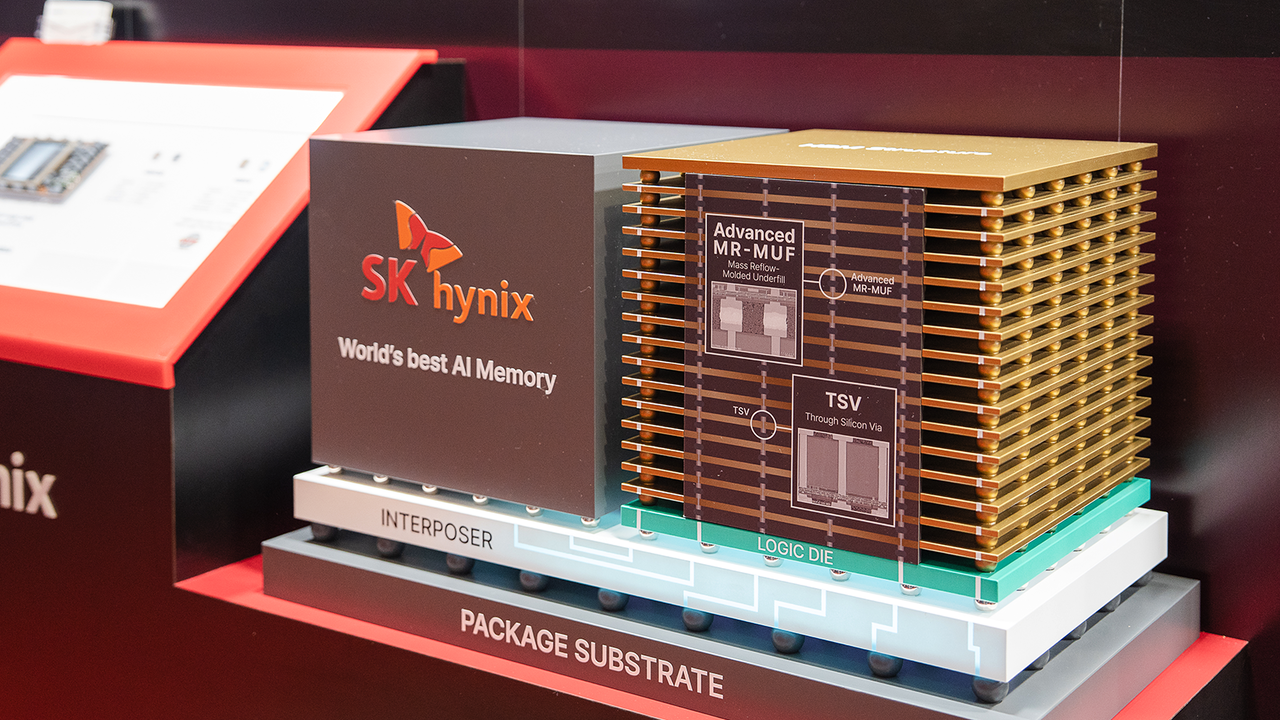

HBM4 箭在弦上,UCM 恰逢其时

就在华为发布 UCM 技术的同时,下一代 HBM4 也做好了最后的准备。6 月下旬,SK 海力士就已经向英伟达小批量供应了 HBM4,用以下一代 AI 芯片 Rubin。在 8 月刚刚举行的闪存峰会(FMS 2025)上,各家也都在朝 HBM4 的量产发起最后的冲刺。

按照 SK 海力士的规划,从 HBM3E 到 HBM4,带宽将提升到原来的三倍,超过 2TB/s。这意味着同样的显卡或 AI 加速卡,在存取速度上会有一次质的飞跃,对大模型的推理和训练都是巨大的性能利好。

图片来源:SK 海力士

另一方面,尽管受限于先进封装工艺的落后,HBM 国产化的努力还在进行中,但已经攻克了 HBM2 工艺,正在加速 HBM3 的量产。

而在这种背景下,华为推出 UCM 技术的价值也更加凸显。前文就提到,UCM 技术并不会消灭 HBM,而是提高 HBM 的利用率,让有限资源发挥出更大的价值。这样一来,即便在硬件不升级的情况下,也能在性能和体验上实现大幅跃升。

从某种程度上,在国产 HBM 尚未完全追赶、进口高端 HBM 获得不易的当下,UCM 可以帮助国内 AI 推理缩小与海外的差距,减少对硬件极限堆料的依赖。即便未来 HBM4 在国内普及,UCM 依然有用——能让每一颗 HBM 发挥更高的效率,把硬件升级的红利最大化。

在 AI 推理进入竞争白热化的今天,这种软硬结合的路径,可以说也为国产 AI 芯片争取了宝贵的时间窗口。更重要的是,这种软硬结合的路径或许也为更多 AI 上下游国产化指明了一个方向。

写在最后

从首 Token 时延最高降低 90%,到上下文窗口扩展 10 倍级,UCM 给人的第一印象是一种「降本增效」的推理加速技术。但它的意义并不仅仅是跑得更快,而是通过重新规划「AI 的记忆层级」,在不增加硬件负担的情况下,释放出有限 HBM 的最大价值。

更重要的是,这意味着国产厂商从 AI 芯片到大模型都可以用更聪明的方式追赶,而不是一味依赖昂贵、稀缺的高端显存。

尤其是在 HBM4 逼近量产,国产化仍需时间积累的当下。UCM 恰恰在这个时间差里提供了一个现实可行的方案,让国内 AI 推理系统在硬件受限的情况下,也能提升体验、缩短差距。

也许未来几年,当国产 HBM 能够稳定供应、HBM4 在国内普及时,UCM 依然会是不可或缺的工具——它不仅让每一颗 HBM 发挥得更高效,还能让硬件升级的红利真正落到应用体验上。

雷科技

雷科技