这两天,有一件比较离谱的事儿在网上发酵,相关话题也频繁登上微博和百度热搜。

而且,大多数网友在看到该事情,都忍不住发出吐槽,甚至是谴责。

很难想象,平日里经常因为观点不同而争锋相对的网友,会在此时变得如此团结。

小雷也不卖关子,直接把事儿摊开来说。

事情经过并不复杂,说的是一位广州女生在地铁拍的美照,被一些别有用心的网友,用AI一键脱衣软件生成了裸体照片。

在AI脱衣处理以后,有网友就把生成好的裸照发到各个微信群,并添油加醋,上演一出造谣狂欢。

图源:微博

不过从时间线来看,这事儿其实发生在三月初。

如今再次登上热搜,可见如今AI那以假乱真的能力,已经实打实引起了人们的焦虑和恐惧。

AI脱衣,已经无法阻止了?

说实话,微信糅合聊天记录进行造谣这种操作,咱们都见怪不怪了。

微信聊天记录是自带“裂变”属性的,人人都可以把聊天记录汇总起来,随意转发给群聊或好友。

而在这个相对封闭的领域里,人们往往会对聊天记录的真实性放松戒备。

从而导致一个无中生有的谣言,一传十,十传百,最终触及到无数微信用户手中。

反正很多人都是图一乐,看完随手就转了。

图源:微信

至于这次的AI脱衣造谣图嘛,小雷也从某个群聊上看到过...

而看完整段记录后,小雷也总算理解到,为啥这段所谓的“三号线美女露出”造谣记录,会传播如此广泛。

因为,那张由AI脱衣软件生成的裸照图,实在是太逼真了...

如果不花30秒细看,压根看不出是AI脱衣处理过的图。

更别说,绝大多数网友都不会细看来源不明的图片,被AI成功瞒天过海。

图源:微信

有了以假乱真的图,再编点文字填充上下文,一个欺骗性极高的谣言就完成了。

而小雷瞅见,很多以为吃到真瓜的网友们,也迫不及待进行了脑补。

什么“主人的任务”、“有钱真好”,各种无端臆想套在了无辜的女生身上。

图源:微信

当然啦,既然是谣言,最终肯定是站不住脚的。

只是网友识破谣言的方法,显得特别“抓马”。

由于该谣言传播太广,一时间,大量网友都在寻找女主本人的社交平台。

最后有人在小红书上找到女主本人,发现这位女博主所发的原图,是正儿八经穿着衣服的...

图源:小红书

谣言走到这里,基本是不攻自破了。

但经过AI助力的谣言,能达到如此恐怖的传播度,还是让大伙担忧了起来。

海量的互联网信息,对于人们来说已经是摄入过载了。

现在又出现各种AI生成的文字、乃至视频,难道人类面对日渐强大的AI内容,已经辨别无能了吗...

或者换个角度思考,能不能上点手段,压制那些专注作恶的AI软件呢?

老粉丝应该有印象,我在两年前就写过一篇关于AI脱衣的文章,当时有人把DeepNude这款脱衣程序,搬到了电报机器人上。

而且啊,那AI脱衣机器人的效率十分惊人。

只需把一张女生照片发送给机器人,机器人就会用AI技术分析被衣服遮挡住的皮肤,接着生成裸照,返回结果。

整个过程行云流水,不用十秒钟就完事儿。

图源:网络

不过呢,生成裸照的速度快是一回事,效果好不好就另说了。

那时候小雷看过不少AI脱衣程序合成的裸照,基本是图一乐的水平,一眼能看出是算法处理过的。

但几年过去,生成式AI飞速进步,AI脱衣的效果也上了N个台阶。

口说无凭,小雷在互联网某个角落里,找到了一款技术较新的AI脱衣程序,咱们一起看看效果如何。

使用方法和两年前一样,还是通过Telegram机器人来操作。

发送图片,等待AI返图,堪称有手就行。

当然啦,考虑到隐私,小雷就不发图过去了。

但在该机器人的群聊中,仍能看到不少经过AI脱衣的图像例子。

和两年前的AI脱衣程序不同,如今经过进化的AI,已经能精准还原身体肤色,和脸部相匹配。

而且边缘处理也很细腻,倘若不抠细节,真的很难发现这是AI生成的...

不过“一分钱一分货”的道理,放在这儿仍然行得通。

相比两年前,现在AI脱衣收费无疑更高,普通版10元两张,定制版50元一张。

你没听错,目前的AI脱衣,已经能做到【定制化】了。

只要用户愿意多付点钱,就能获得更多自定义选项。

普通版默认只帮你“脱掉”人物的衣服,没有多余操作,而定制版则能帮你把衣服换成情趣内衣啥的...

听着很离谱对吧,但这就是AI现在能做到的事儿。

本质上来说,AI绘图都需要经过大量素材训练,主打的就是“大力出奇迹”。

开发者给AI模型投喂的训练素材越多,AI生成的图就越真实。

而随着时间推移,现在开发者喂给AI的素材数量,已经按亿来计算了。

加上模型和算法的双双进步,AI绘图在练习时长两年半的生涯中中,早已变得无比成熟。

就拿OpenAI旗下的DALL-E模型来说吧,它足足有120亿个参数,在2.5亿个图像文本对上进行训练。

图源:insidetelecom.com

在这个基础上,它不仅能扩展图片信息,还能生成极其写实的图片。

更关键的是,这还不是AI的天花板。

不断进击的AI,可能要被紧急叫停

随着AIGC的光速发展,小雷有一种预感,那就是以后的互联网,会充斥着各种AI生成的信息。

真真假假,难以分辨。

像是前阵子Midjounrney V5模型发布,就让AI绘画的以假乱真程度,达到了巅峰。

以往AI往往是画不好手指的,但现在大伙能看到,它画出的手指已经没啥违和感了。

图源:推特

以往AI也是画不好真人的,有时候刻意以写实风输出图片,还可能引起恐怖谷效应。

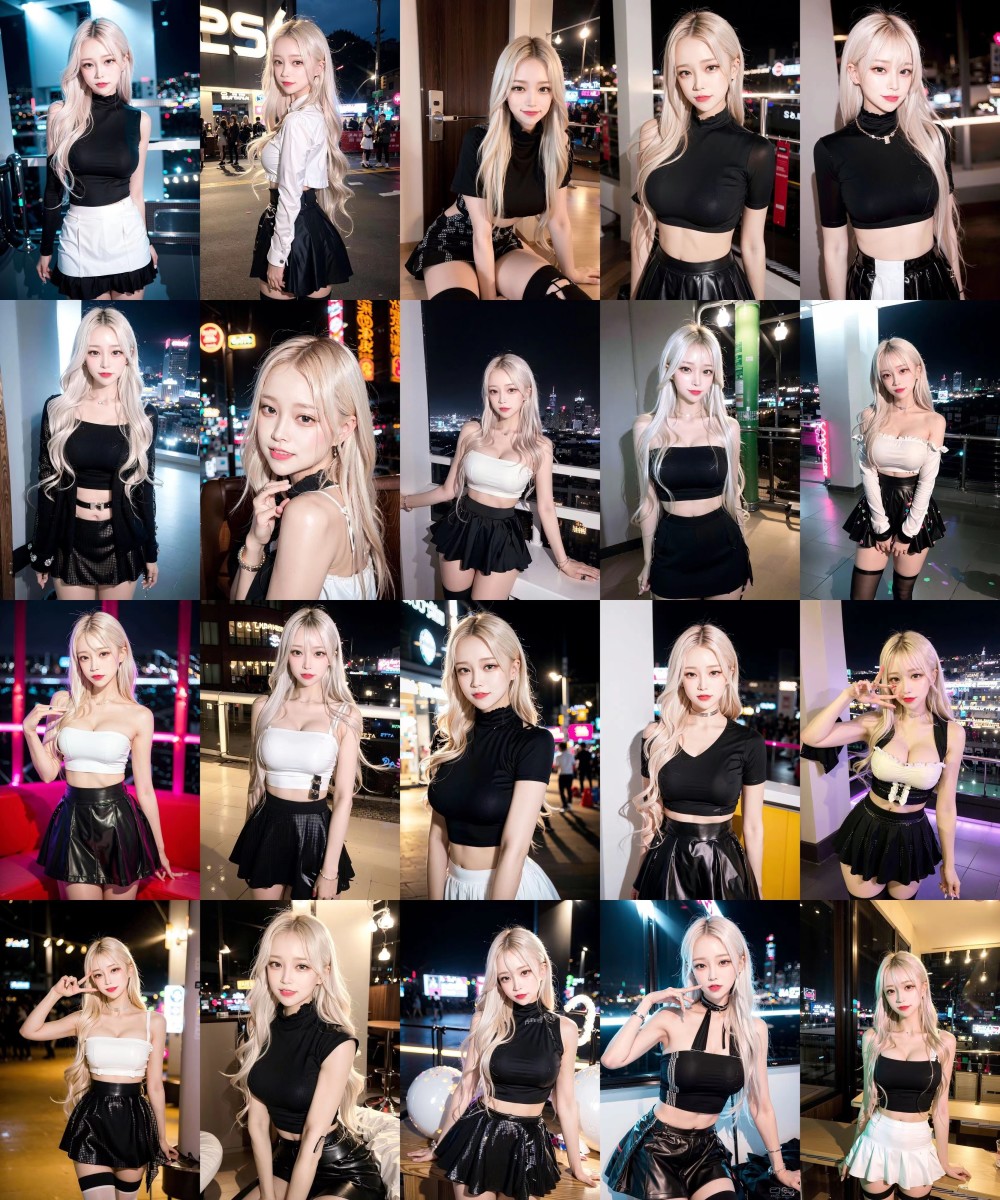

可现在,画一个美女都像模像样的,主体自然,背景也没啥大异常。

图源:小雷哔哔

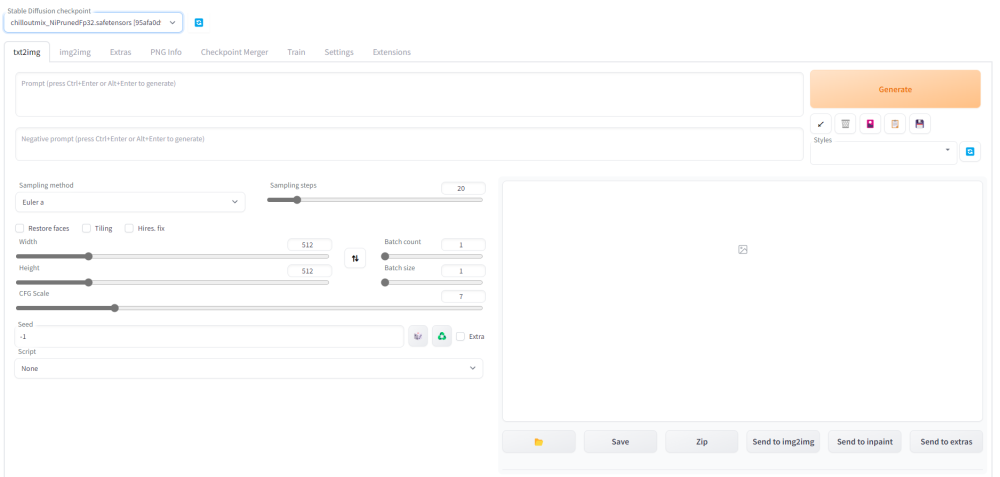

大伙也别以为要生成这些图,门槛很高。

其实市面上有很多在线模型可以使用,也有一键把模型搭建到本地的教程。

只需动动手指,敲几个关键词就能生成出来。

图源:小雷哔哔

那生成人物这方面做好了,AI对复杂背景的处理又是啥水平呢?

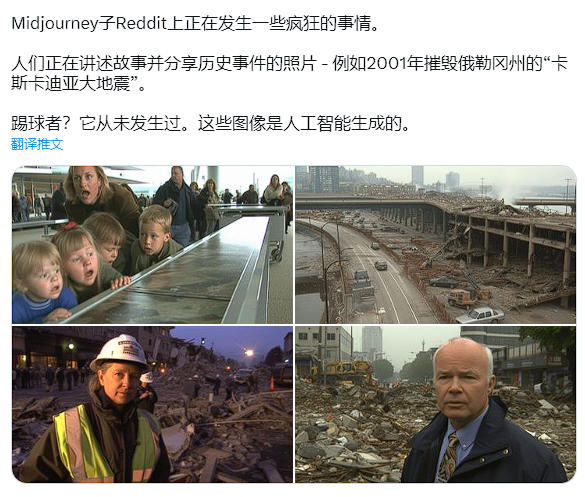

就这么说吧,自从Midjounrney V5模型发布以后,各大社交平台都乱套了。

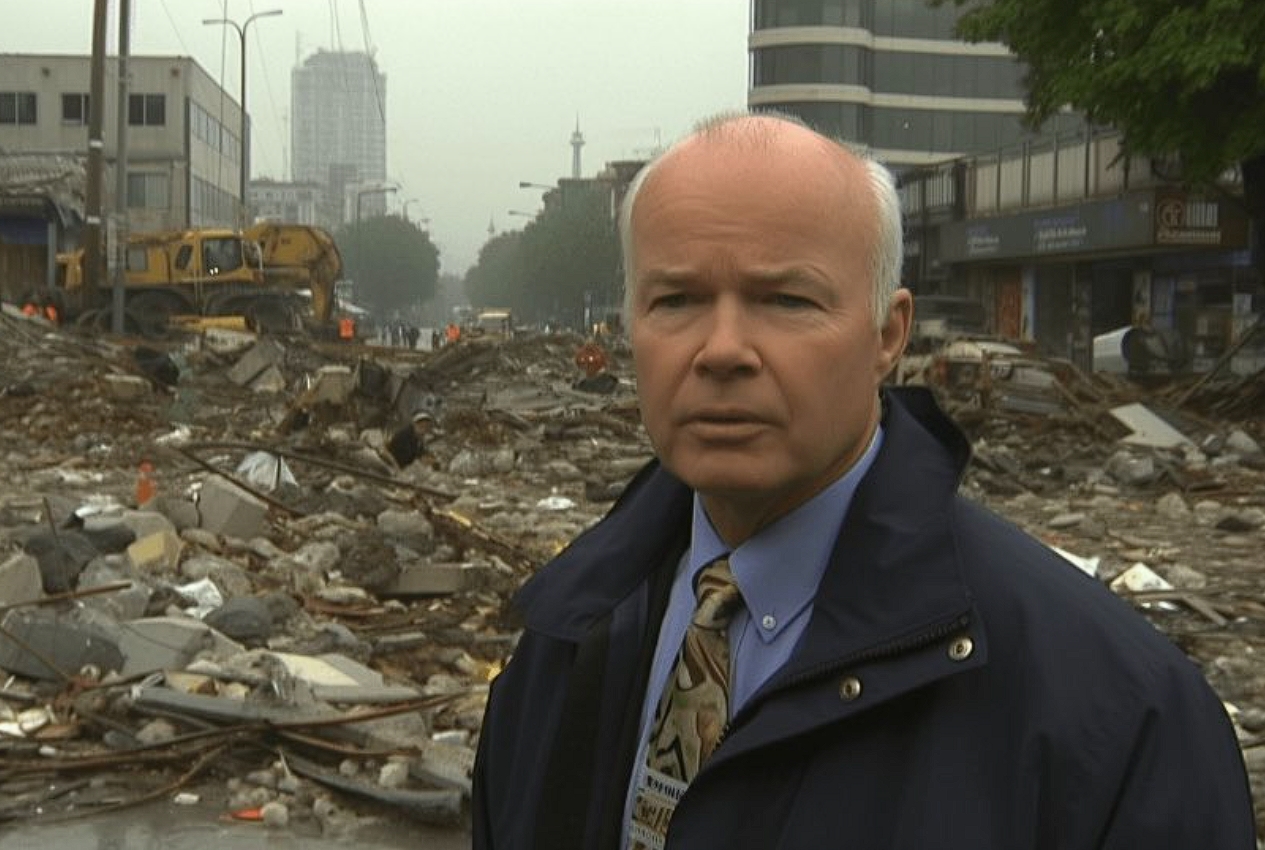

前几天,有网友放出了几张图,并表示是2001年真实发生过的地震灾难。

略带年代感的画风和DVD画质,把人带回了那个年代。

图源:推特

还有记者在灾后现场的一线报道,都让网友们深信不疑。

图源:推特

结果怎么着,这几张图都是由Midjounrney V5生成的...

除此以外呢,还有特朗普被捕和教皇穿羽绒服等AI生成图,都在社交平台大火。

可能这种图还有破绽,会有网友认出是假的。

但说实话啊,网民数量这么多,总会有那么一部分人信以为真的,这就足以造成很大的负面影响。

图源:推特

和AI飞速发展不同,关于监管AI的法律法规仍未跟上。

所以目前AI到底能不能合规发展,完全靠背后的公司自觉。

比如Midjounrney就紧急关闭了免费试用的通道,减少网友对AI绘图的滥用。

而AI文字领域这边,ChatGPT最近也被美国一家安全机构盯上了。

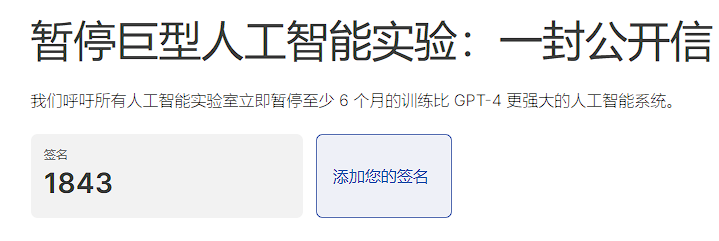

上千位AI大佬联合签名,抵制AI巨头暂停研发比GPT-4更强的人工智能。

图源:futureoflife.org

但小雷觉得,人工智能这玩意儿,就像个潘多拉魔盒。

一旦打开,就很难阻止它继续发展了。

只希望相关监管和法律法规,能尽快跟上叭,不然光是AI脱衣这种程序,就足以困扰到普通人了。

雷科技

雷科技